使用Docker安装n8n并配置ollama本地模型

安装

官方安装命令,要先安装docker客户端。

1 | docker volume create n8n_data |

安装到第二步时报错:

1 | docker run -it --rm --name n8n -p 5678:5678 -v n8n_data:/home/node/.n8n docker.n8n.io/n8nio/n8n |

需要翻墙

或者

根据:docker.n8n.io/n8nio/n8n:latest · Issue #3081 · kubesre/docker-registry-mirrors提示使用:

1 | docker run -it --rm --name n8n -p 5678:5678 -v n8n_data:/home/node/.n8n docker.n8n.io/n8nio/n8n:latest |

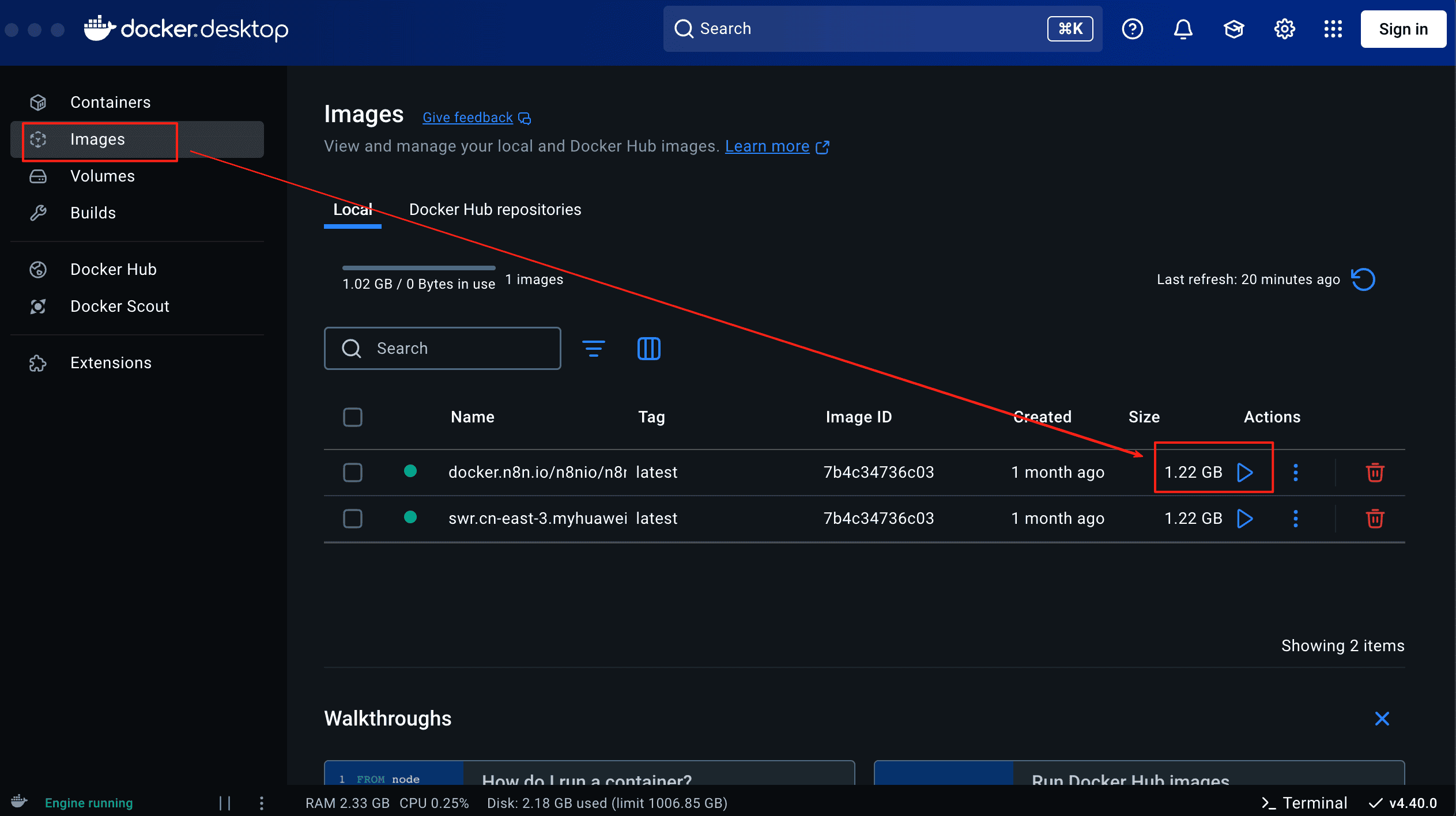

或者使用镜像的:

1 | # Docker 拉取命令 |

可以拉取成功

然后启动,

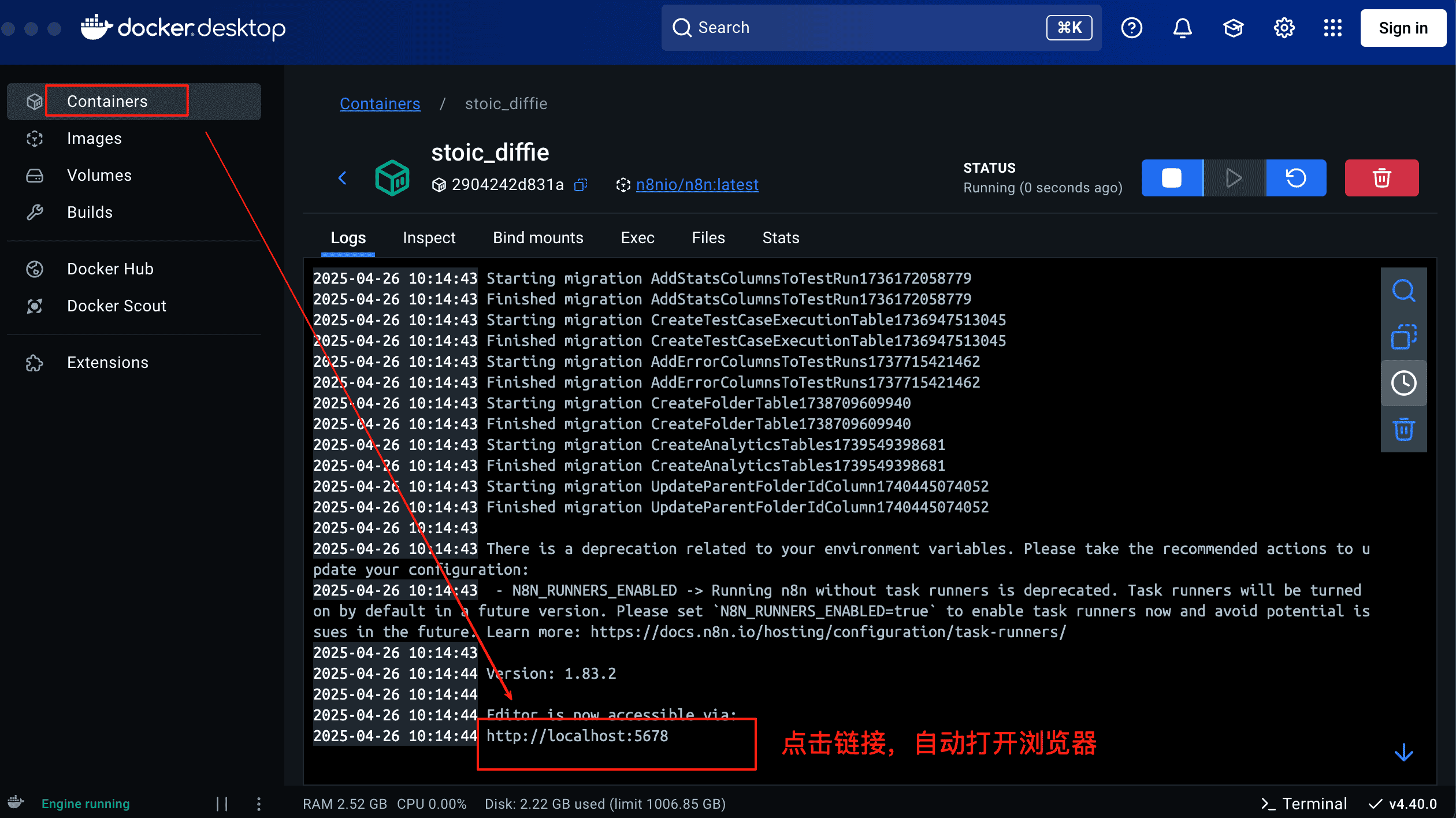

开启后自动跳转到如下页面,点击下面链接,

使用n8n创建工作流

创建工作流

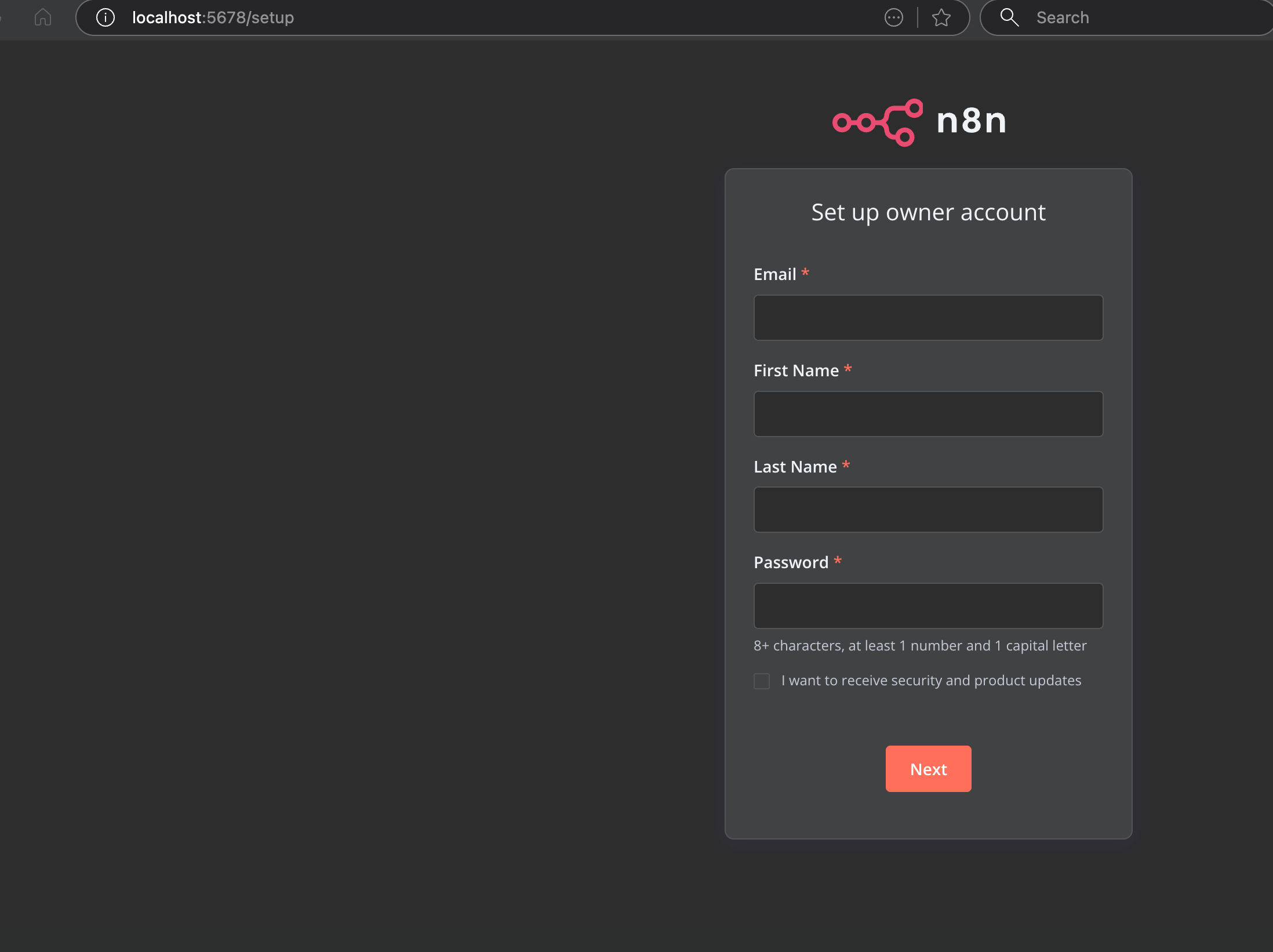

点击打开网页如下

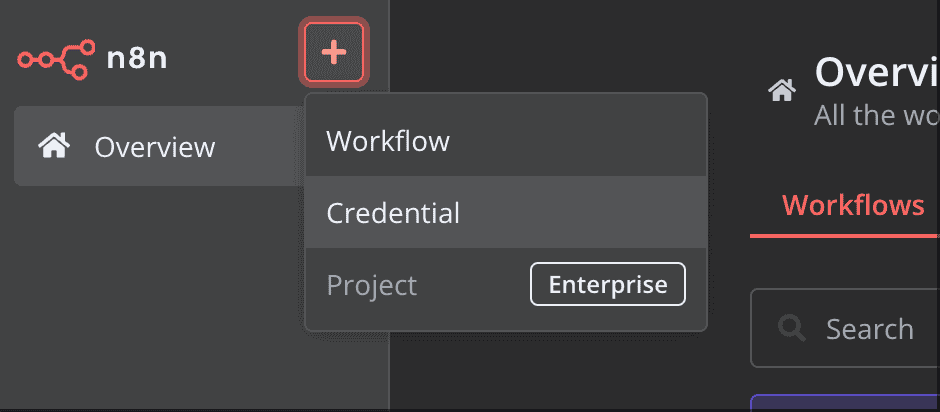

注册进入,点击左上角,创建工作流

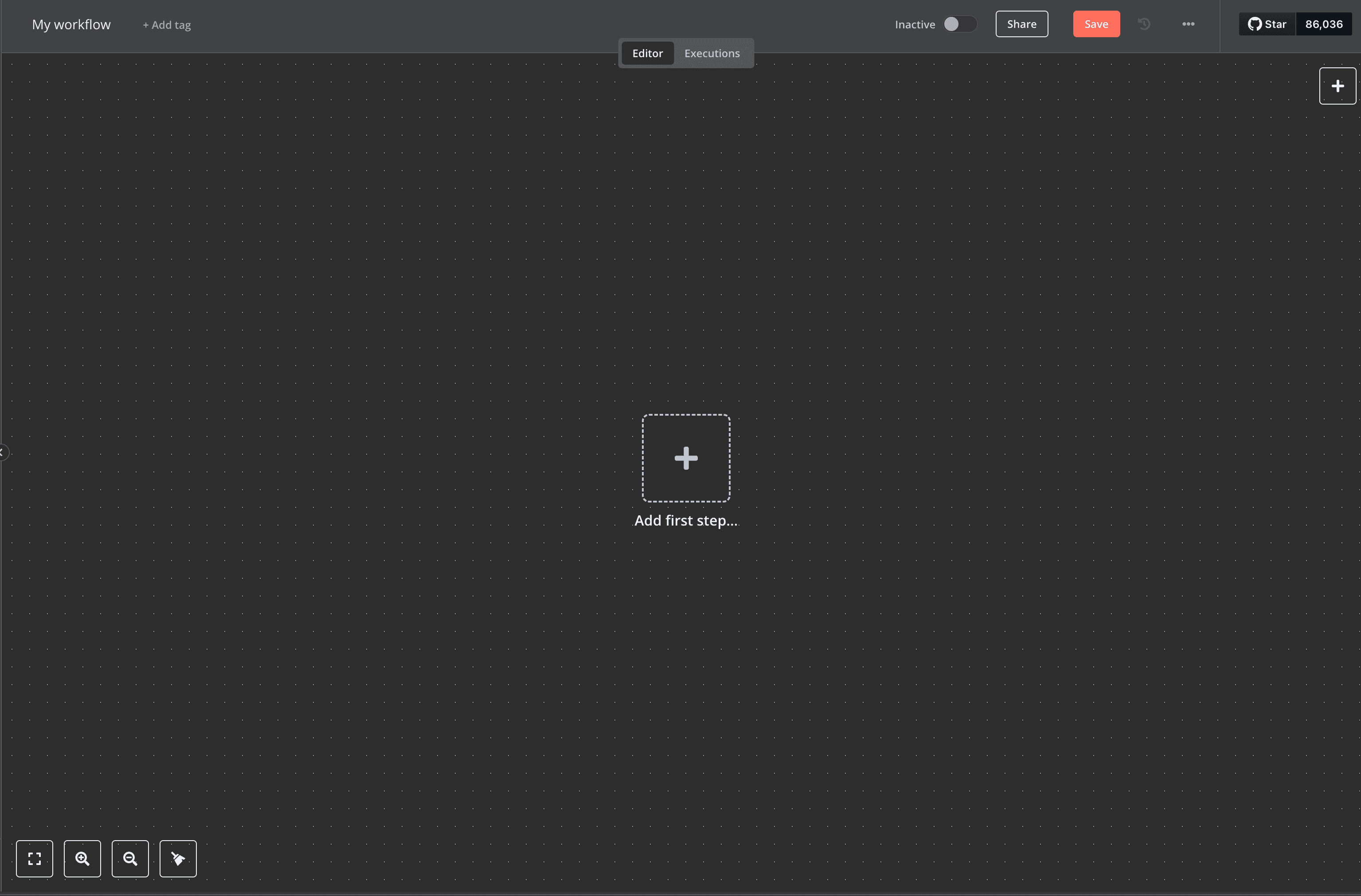

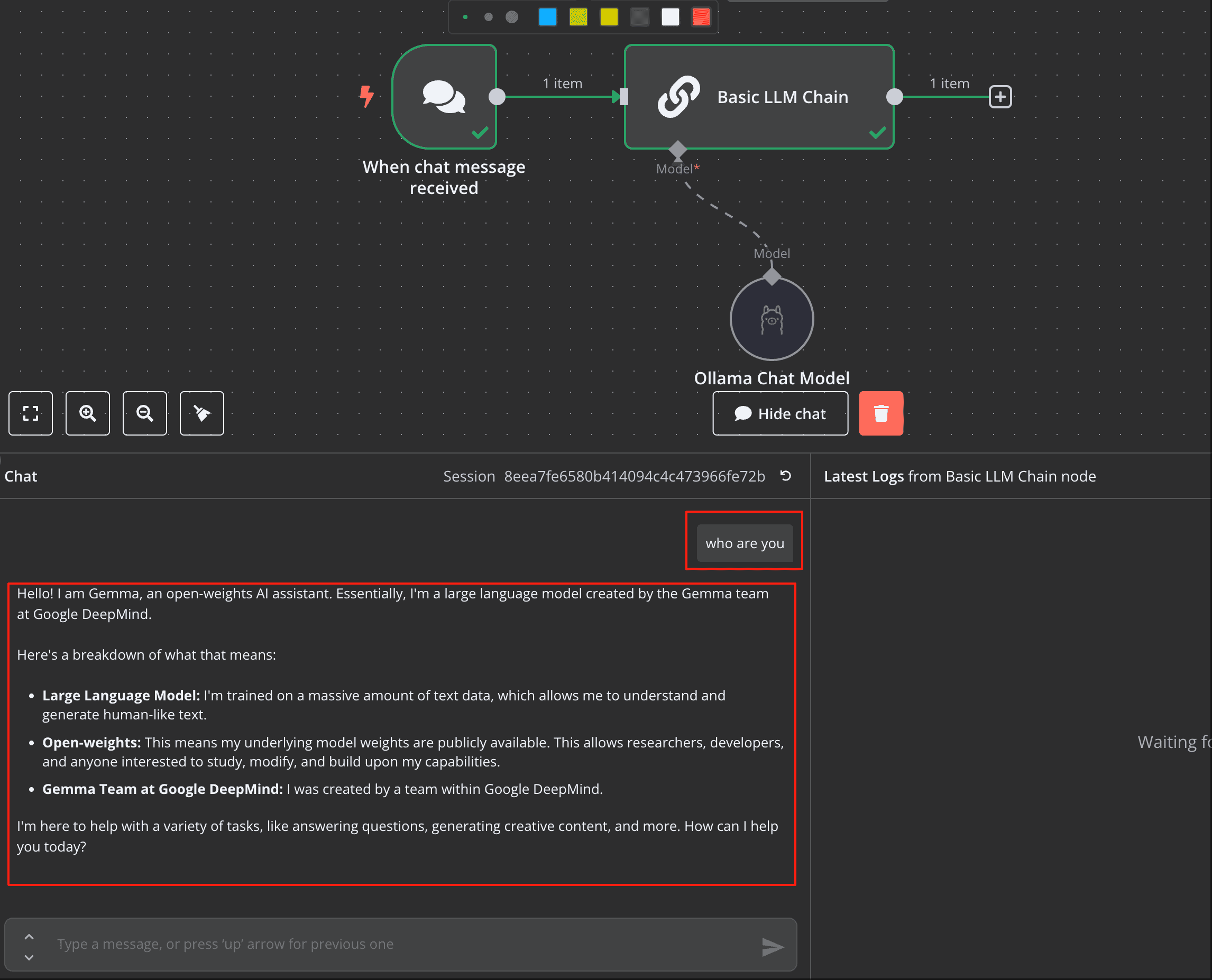

创建完成如下图:

创建聊天窗口节点

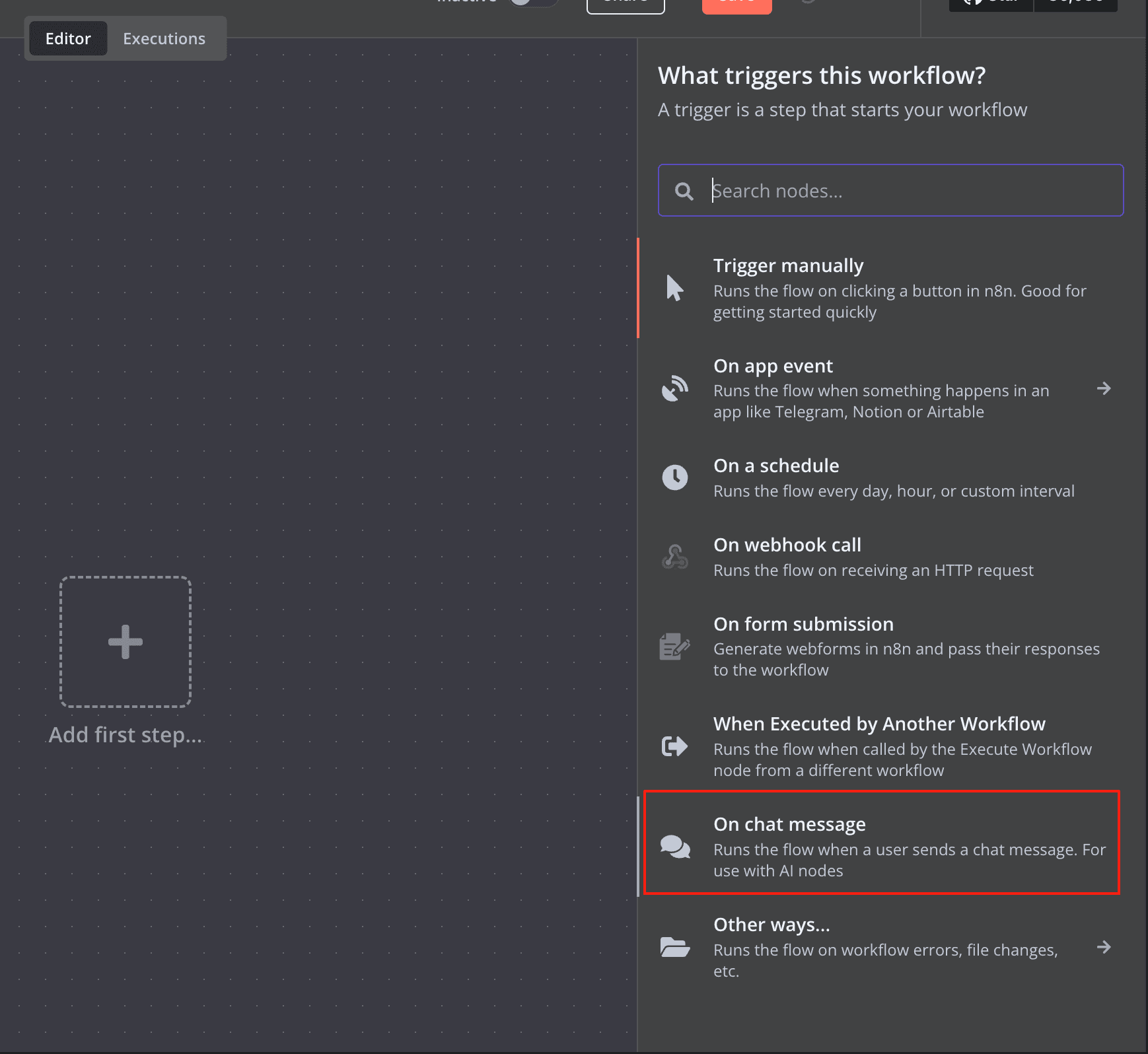

点击中间加号,创建节点,

选择On chat message,聊天窗口节点

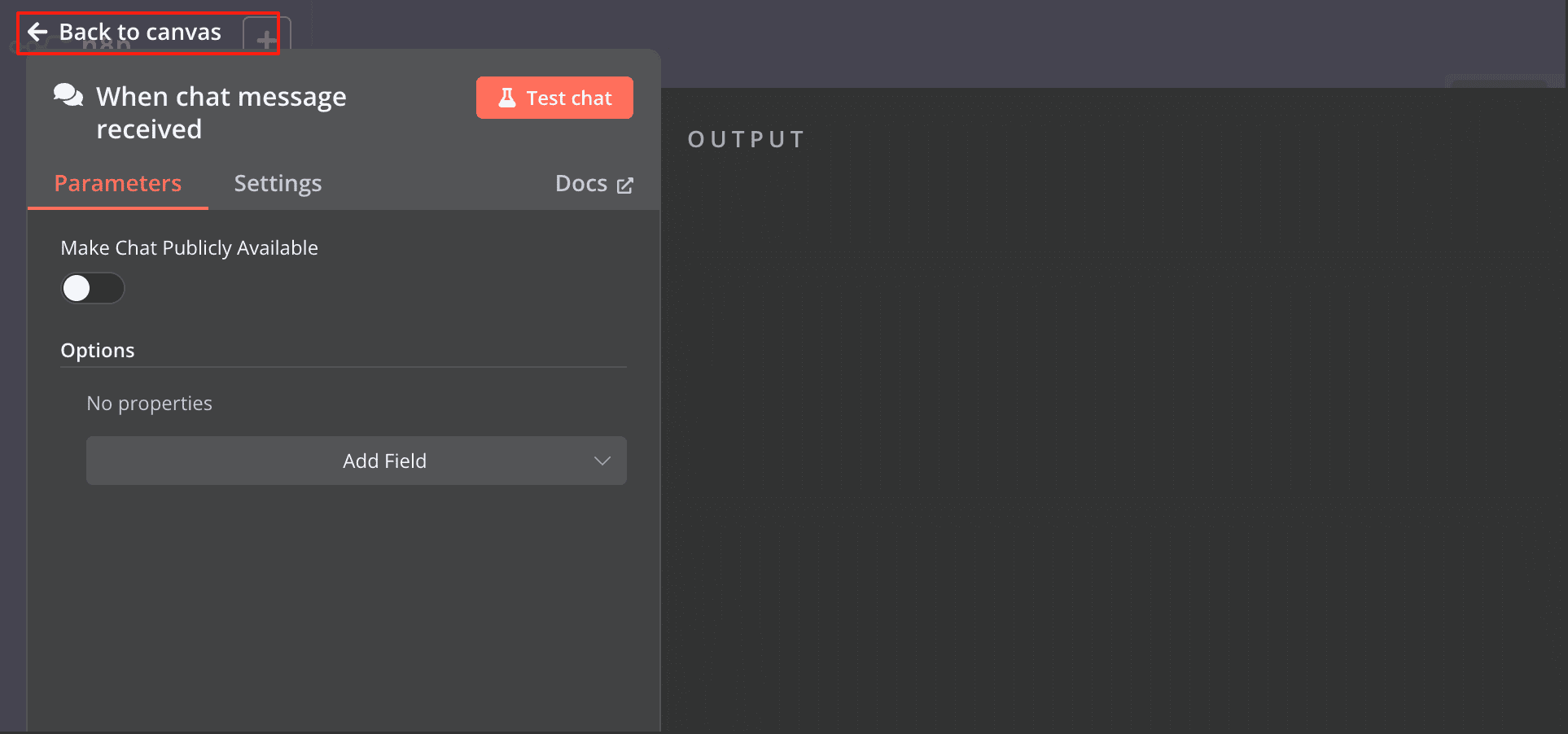

点击Back to canvas返回主界面,

添加AI节点

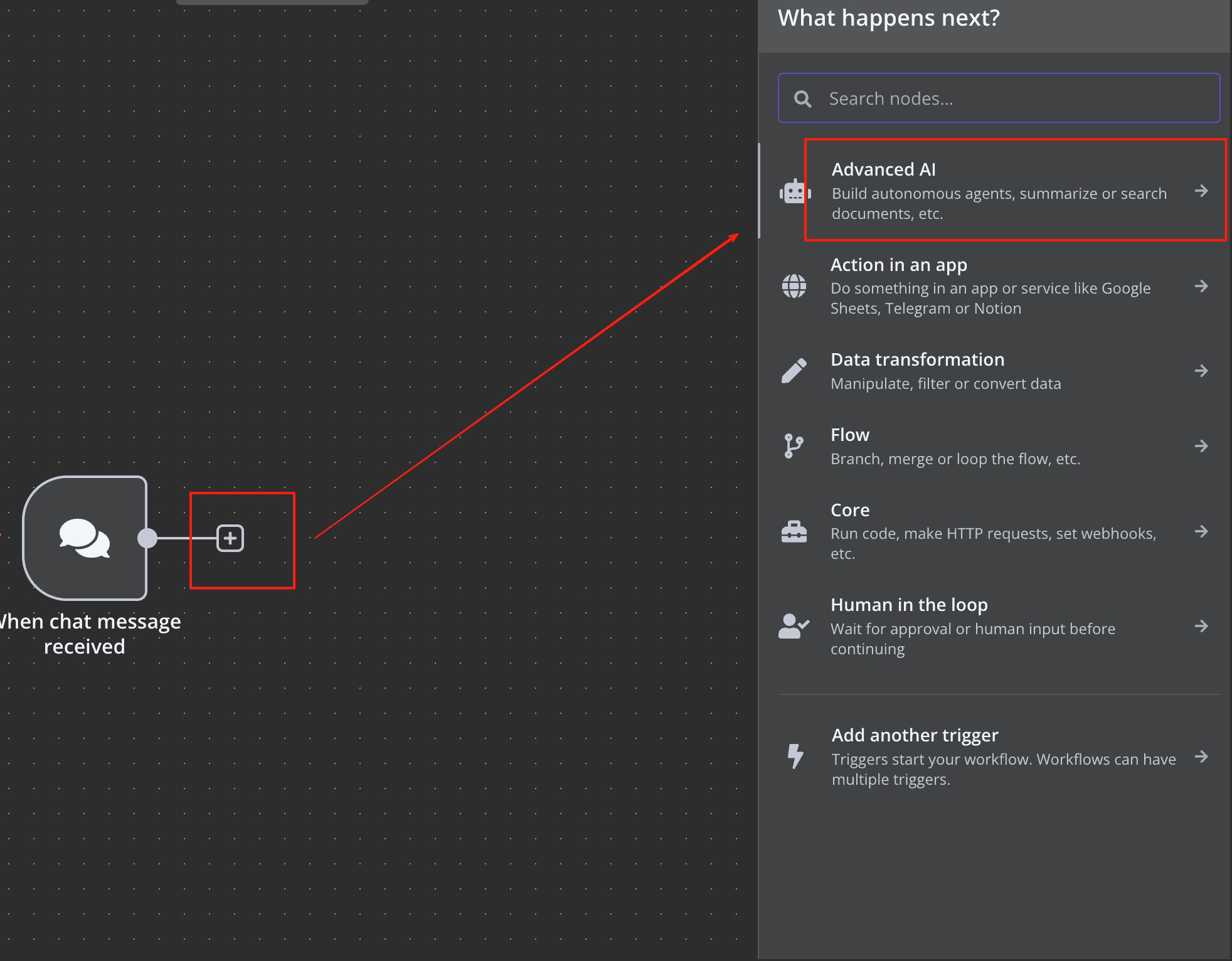

继续点击后面的加号,然后点击Advanced AI,

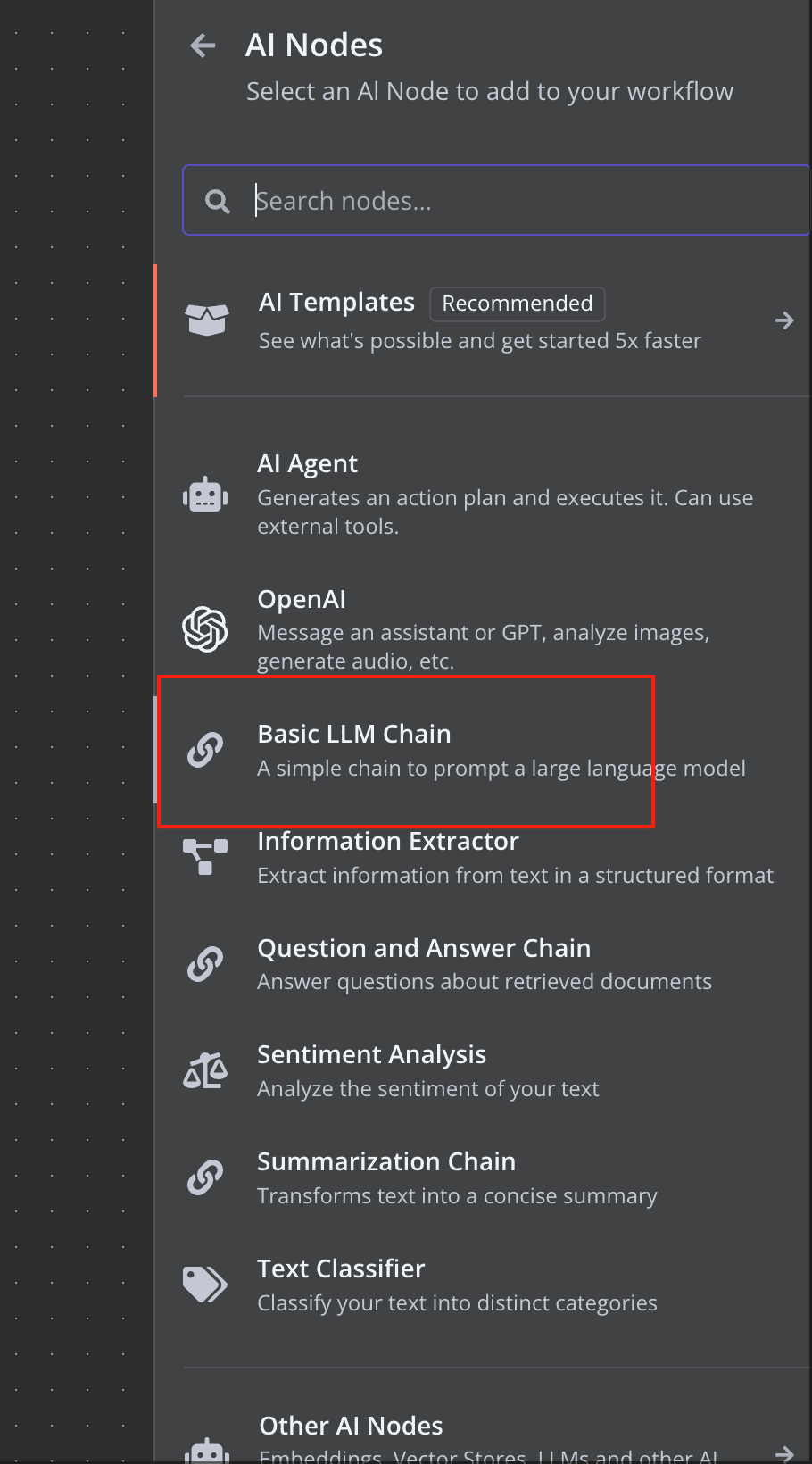

选择Basic LLM Chain

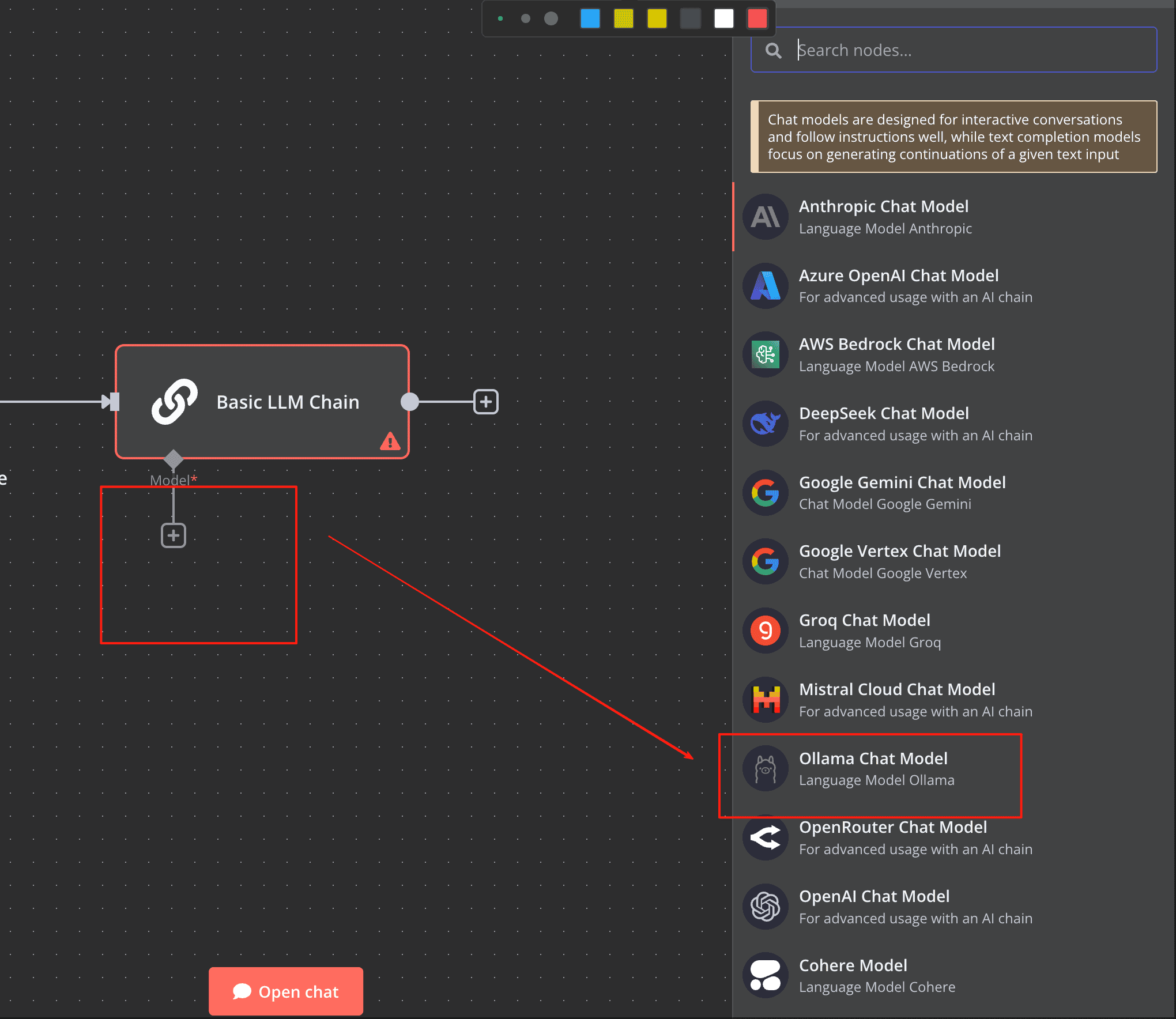

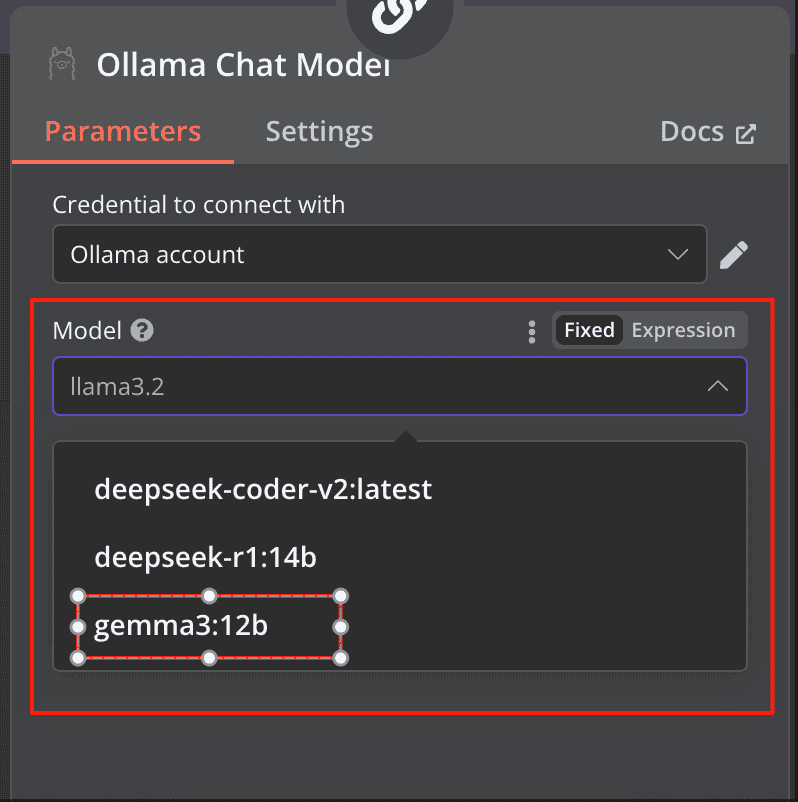

点击加号,然后选择 Ollama Chat Model

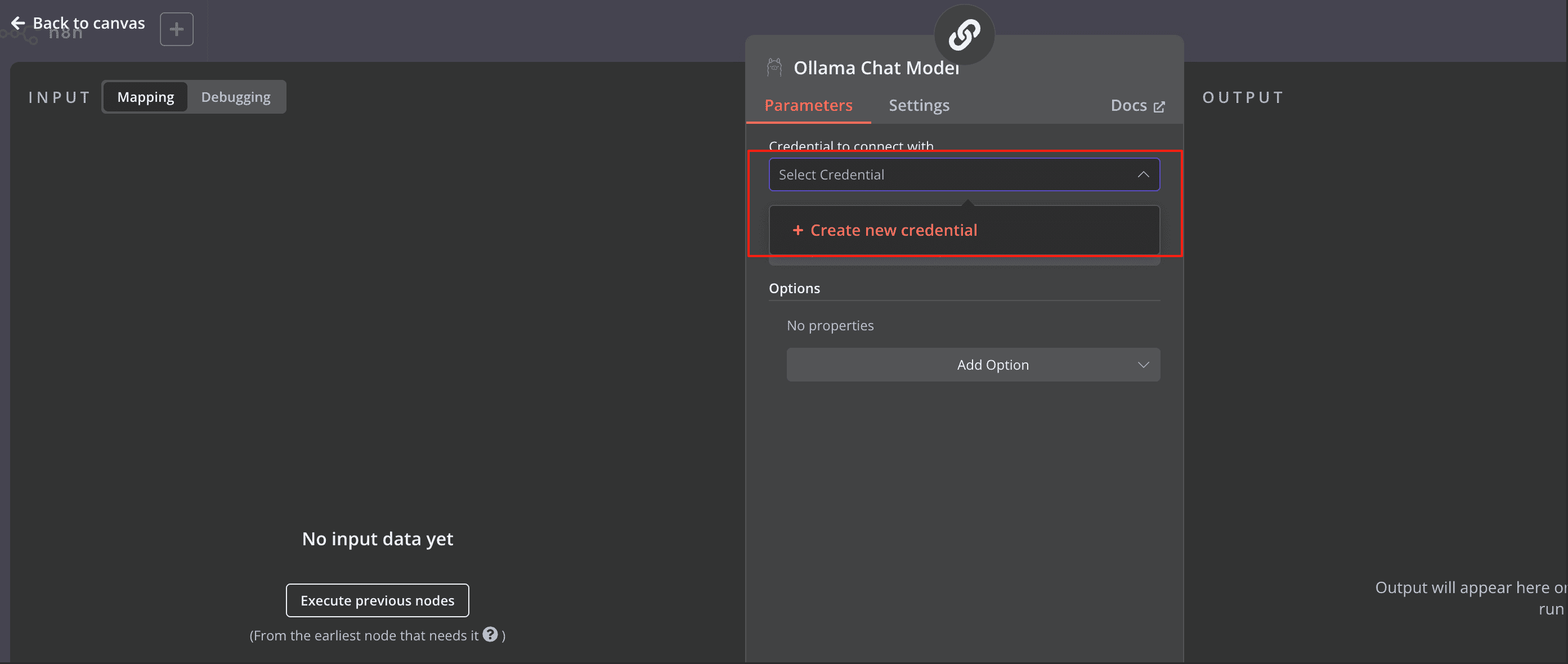

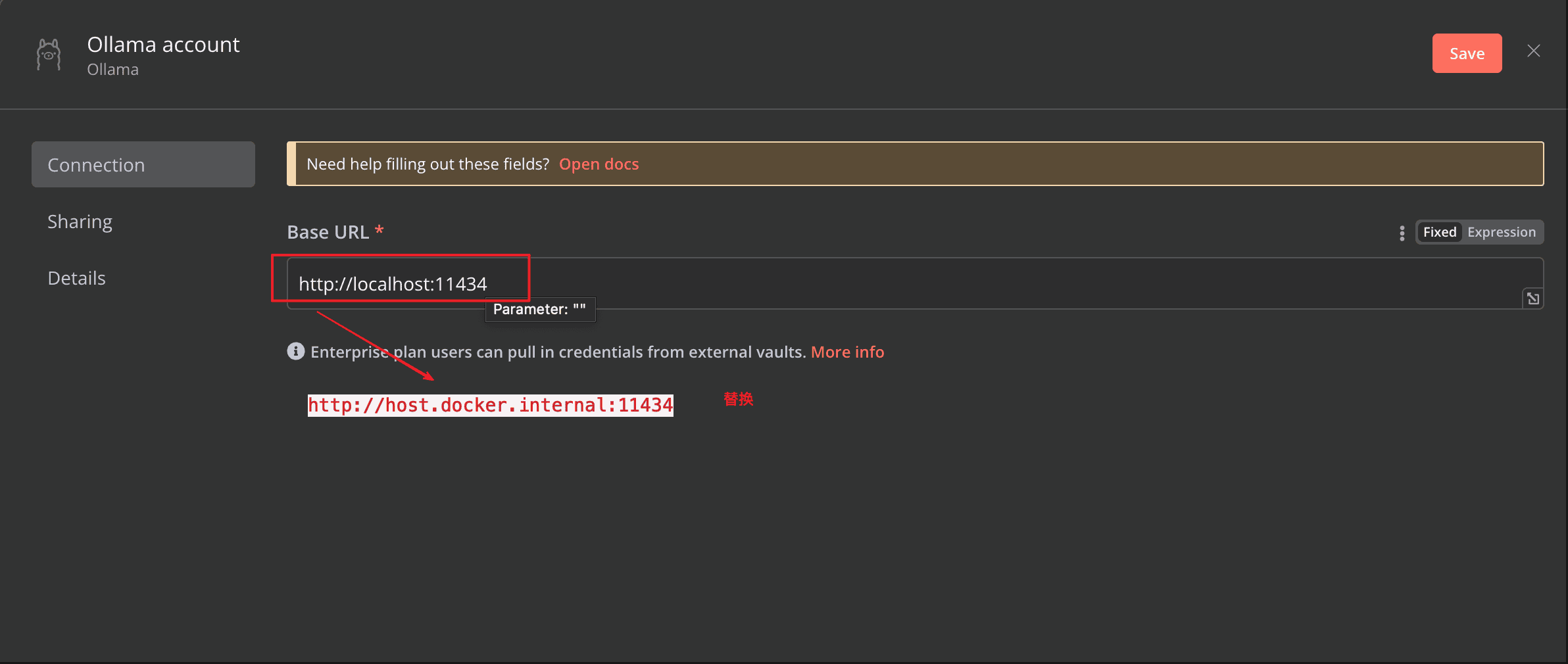

点击Select Credential -> Create new credential

docker中启动的修改Base URL(http://localhost:11434)为:`http://host.docker.internal:11434`,点击保存

链接成功,返回选择模型:

选择完成后:

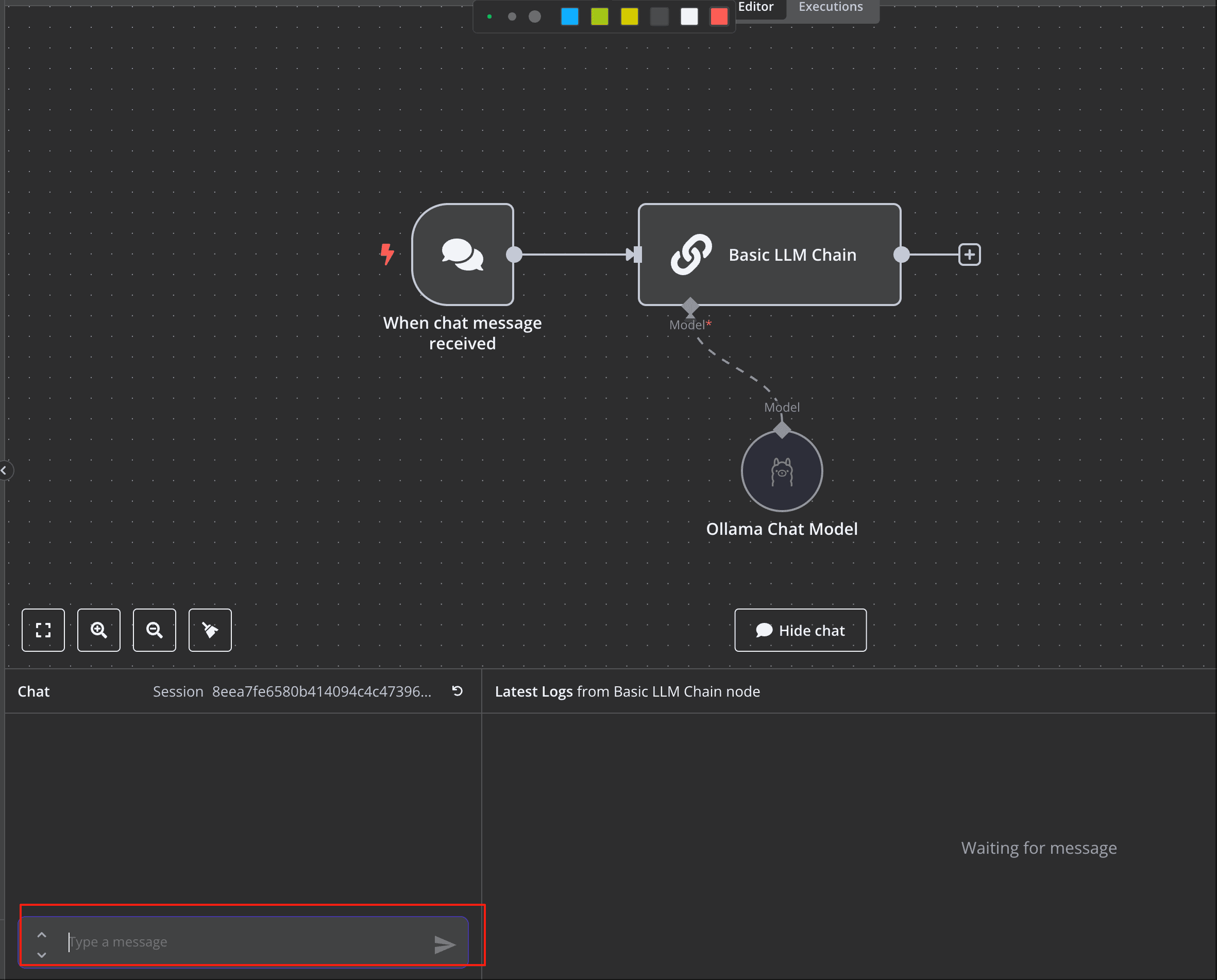

创建完成

就有了选好的模型节点,在输入框输入信息,

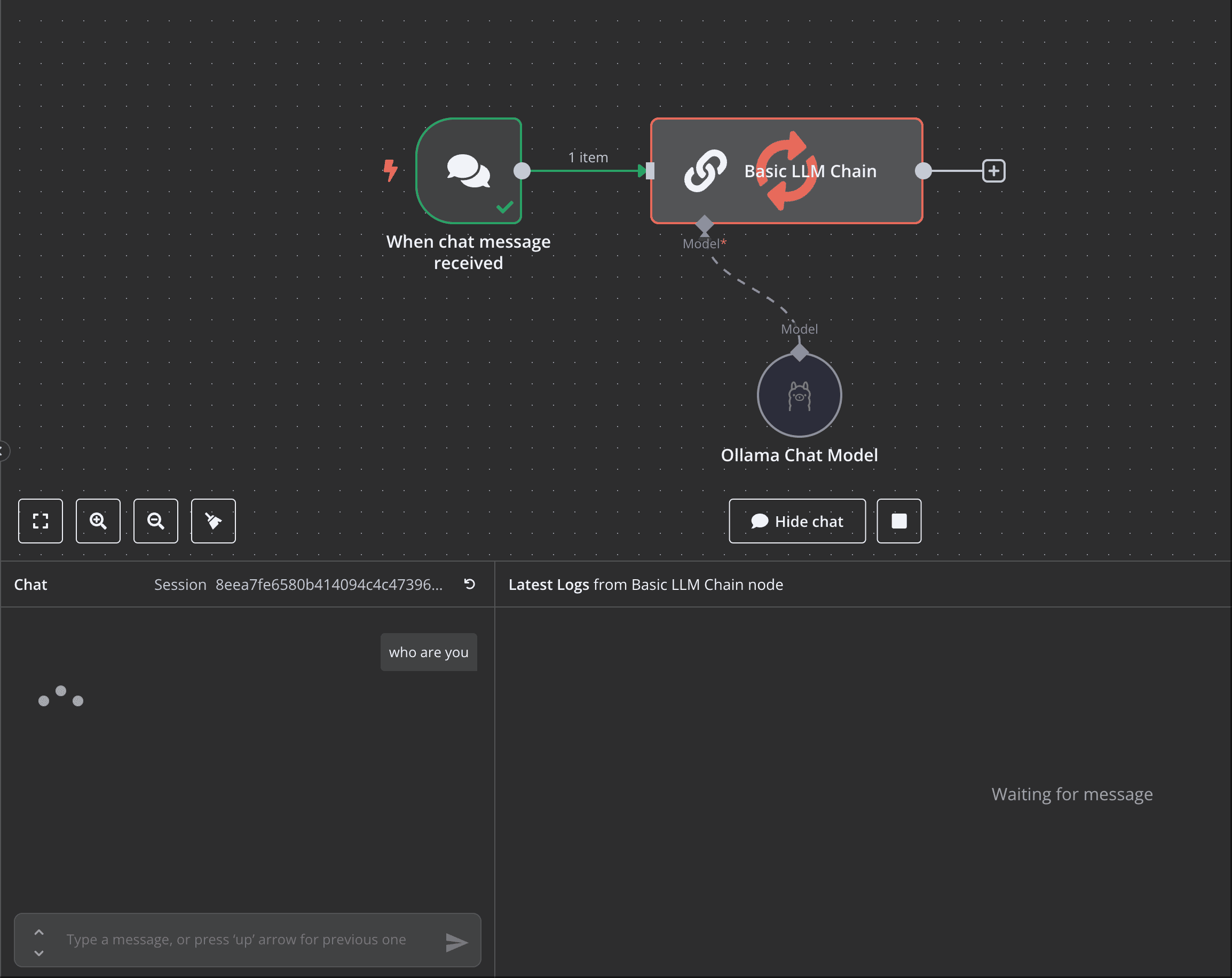

等待加载信息

返回了信息,这个就是本地模型Gemma返回的。

后面会介绍一下n8n + MCP的创建,还有一些实战工作流的创建。

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来自 墨香博客!